智通財經APP獲悉,日前,在NVIDIA GTC 2024上,聯想車計算發佈了全新的支持包括NVIDIA DRIVE等平臺的大模型中間件Ultra Boost,包括AI模型引擎及AI編譯器等工具鏈,旨在助力大模型在車端部署,結合多模態的人機交互技術,賦能車內智能拓展更多應用場景。在CES 2024上聯想(00992)首次展示了基於汽車場景大模型的座艙智能助理,在此次GTC2024上,車計算團隊利用大模型中間件 Ultra Boost快速地將該智能助理應用部署至NVIDIA DRIVE平臺。

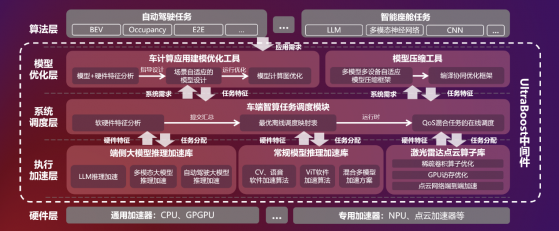

聯想車計算智駕平臺大模型中間件 Ultra Boost架構圖

大模型生態快速崛起,AI應用需求日益複雜,模型部署面臨巨大機遇與挑戰。與此同時汽車AI芯片的迭代也需要兼顧不同應用需求。芯片架構需要適配AI算法模型以及增加算法模型引擎。爲了提高 AI 計算效率,特別是針對基於 transformer 的算法,下一代 NVIDIA DRIVE Thor 平臺採用 Blackwell 架構,可實現生成式 AI 功能,該系統在 NVIDIA 最先進的數據中心 AI 解決方案上進行了訓練。

與此同時,爲了進一步發揮AI芯片平臺的性能,加速客戶的AI開發和部署效率,聯想推出了AI模型引擎Ultra Boost:針對NVIDIA DRIVE平臺,該引擎將提供一套軟硬一體的端到端AI性能優化方案。在應用層,提供場景自適應的建模優化工具、硬件感知的模型壓縮工具,可在極低的精度損失範圍內大幅降低模型計算量;在調度層,提供專用於自動駕駛的調度中間件,該中間件基於自研的靜態+動態調度算法打造,在保證實時性的同時提升了系統的執行效率;在執行層,該引擎提供多種算法加速庫,涵蓋AI大模型加速、多媒體任務流加速、激光雷達點雲加速,應用場景可覆蓋智能座艙和自動駕駛;在編譯層,聯想車計算自研的AI編譯器SpeedWise,可針對普通模型和大模型,以及不同目標硬件完成編譯和優化。

在此基礎上,聯想車計算推出的AI模型引擎,基於英偉達AI芯片的多項技術,包括Continuous Batching來提升推理吞吐率,降低推理時延;面向硬件Graphic Rewriting技術來優化大模型網絡結構的同時,還基於聯想車計算自研的大模型低比特量化技術來加速大模型推理,並且建立了面向NVIDIA DRIVE平臺的自動調優機制實現了全自動的模型優化,快速且成功的將聯想自己的智能助手應用部署。

聯想車計算此次發佈的面向智能駕駛的AI中間件 Ultra Boost,支持業界多個主要大模型的自動化部署和加速,將助力客戶縮短開發週期,打造性能卓越,成本更優的智能駕駛解決方案。

在NVIDIA GTC 2024上,聯想車計算展示了多款自動駕駛域控平臺。