美國超微公司(AMD.US)於2024年7月30日,在美股市場收盤後,正式發佈了其截至2024年6月29日的第二財季財報。

CEO蘇姿豐在業績發佈會上透露,與英偉達(NVDA.US)AI芯片H100競爭的MI300季度收入首次超過10億美元,一下子讓華爾街沸騰起來,AMD的股價迎來久違的大漲,盤後交易時段大漲超9%。

實際上,不考慮盤後交易時段的大漲,AMD今年以來的股價累計跌幅達6.09%,遠遠落後於英偉達的累計漲幅109.49%,亦落後於納斯達克指數的累計漲幅14.23%。

按每股138.44美元計,AMD當前總市值為2,237.6億美元,僅相當於英偉達市值2.55萬億美元的8.6%,差距仍很大。

盤後股價的大幅上漲,無疑為AMD的投資者帶來了期待已久的利好消息,仿佛久旱之地終逢甘霖,來之不易。

AI業務強勁增長

2024年第2季,AMD錄得收入58億美元,按年增長9%,按季增長7%,因數據中心和客戶分部收入的強勁增長,抵消了遊戲和内嵌業務分部收入的下降。非會計準則(下同)毛利率為53%,按年提高340個基點,主要受到數據中心收入增加的帶動。

經營開支按年上升15%,至18億美元,因其持續投資於研發以把握AI增長所帶來的重大機遇。非會計準則經營溢利為13億美元,按年增長18%,經營利潤率達到22%,而上年同期為20%,上個季度為21%。攤薄後每股盈利為0.69美元,按年增長19%。

其AI業務所屬的數據中心分部季度收入增長115%(或15億美元),至26億美元,數據中心大約佔了其總收入的50%,主要受到Instinct MI300 GPU交付量大幅爬升,以及霄龍CPU銷售額實現雙位數強勁增長所帶動。

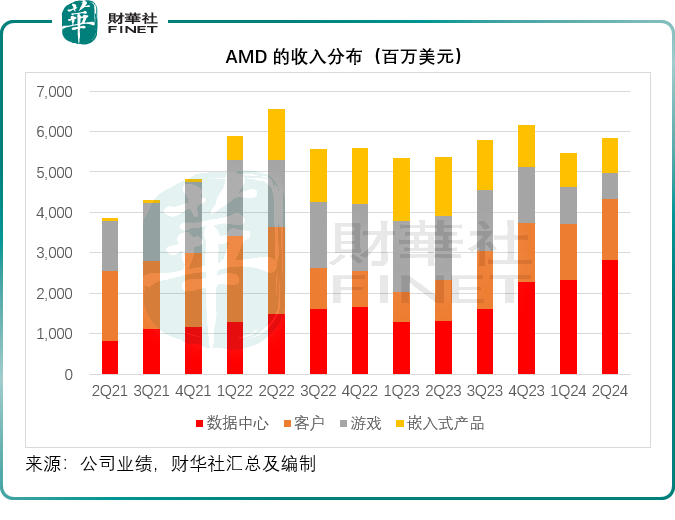

見下圖,在AI的加持下,AMD的數據中心分部收入大幅提升,到2024年第2季,佔總收入的比重已達到49%,而上個季度為43%,上年同期為25%。

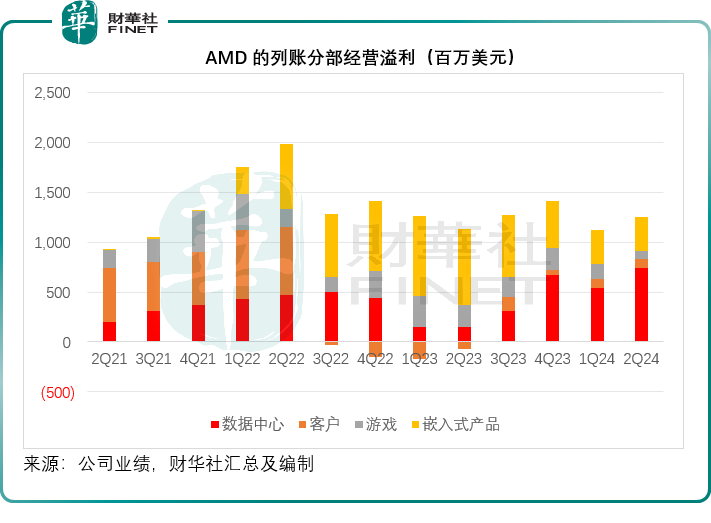

同時,數據中心的經營利潤也大幅提升,第2季的分部經營溢利為7.43億美元,按年增長四倍以上,分部經營利潤率達到26%,而上年同期僅11%,上個季度為23%,主要得益於收入增長以及經營槓桿的改善,抵消了其對研發投入增加的負面影響。

客戶分部季度收入為15億美元,按年增長49%,和按季增長9%,主要受到AMD銳龍加速器銷售增長帶動,經營利潤為8900萬美元,經營利潤率為6%,而上年同期為經營虧損6900萬美元。

遊戲分部季度收入為6.48億美元,按年下降59%,按季下降30%,收入下降主要因為收入的減少主要因為半定制庫存消化和低端市場需求。分部經營溢利為7700萬美元,分部經營利潤率為12%,而去年同期的經營溢利高達2.25億美元,經營利潤率達到14%。

嵌入式產品的季度分部收入為8.61億美元,同比下降41%,客戶的庫存水平繼續正常化。從環比來看,嵌入式部門的收入增長了2%,分部經營溢利為3.45億美元,分部經營利潤率為40%,顯著低於去年同期的經營溢利7.57億美元和經營利潤率52%。

第2季,AMD的經營活動產生淨現金流入5.93億美元,自由現金流為4.39億美元,存貨按季增加3.39億美元至50億美元,因數據中心GPU產品的持續攀升。期内,AND向股東回饋3.52億美元,回購了230萬股,還剩下52億美元的回購授權額度。

AMD人工智能業務的最新進展

AMD的數據中心GPU收入連續第三季創紀錄,其中MI300季度收入首次超過10億美元,遠超市場預期。

在業績發佈會上,蘇姿豐透露,AMD的「AI朋友圈」和業務規模正不斷擴大。

MI300收入大增背後,正是得益於「AI朋友圈」中的Meta和微軟(MSFT.US)等大型科技公司。

微軟也成為第一家在季度内宣佈MI300X實例全面可用的超大規模企業。

據悉,微軟擴大了MI300X加速器的使用範圍,賦能GPT-4 Turbo和多項Copilot服務,包括Microsoft 365 Chat、Word和Teams。

此外,戴爾、惠普、聯想和超微電腦(SMCI.US)都在構建Instinct平台,多家超大規模二級雲供應商也將在本季度推出MI300實例。

在本月初,AMD宣佈計劃收購歐洲最大的私人AI實驗室Silo AI,為多家企業和客戶開發定制AI解決方案。

據悉,Silo團隊展現出了為大型企業客戶提供可擴展服務的能力,能夠增強他們在大模型開發領域的專業知識儲備。此舉有望進一步促進AMD推理和訓練解決方案的優化進程,加快其發展速度。

除了收購Silo AI、Mipsology和Nod,AMD在過去的12個月還向12家人工智能公司投資了超過1.25億美元,以擴展AMD人工智能生態系統,為合作夥伴提供支持。

展望未來,從路線圖的角度來看,AMD正在加速和擴展其Instinct路線圖,每年都會推出新的AI芯片,而今年稍後將推出MI325X。

MI325X使用與MI300相同的基礎架構,通過提供比競爭產品高兩倍的内存和高1.3倍的峰值計算性能,提升其生成式AI性能。

此外,AMD計劃在2025年推出基於新CDNA 4結構的MI350系列,與CDNA 3相比,CDNA 4架構的性能有望提高35倍。這些新產品將直接與英偉達的AI芯片進行競爭。

基於CDNA Next架構的MI400系列正在取得重大進展,AMD計劃於2026年推出。

人工智能解決方案方面,博通、思科、惠普、英特爾、谷歌、Meta和微軟,加入了Ultra Accelerator Link(超級鏈),這是一項行業標準技術,可連接數百個基於AMD經驗證之Infinity Fabric技術的人工智能加速器,因此也被業界戲稱為「復仇者聯盟」,對撼英偉達的NVLink。

蘇姿豐表示,通過將UALink與廣泛支持的超以太網聯盟規範相結合,他們正在建立一種標準化方法,用於大規模構建下一代高性能數據中心人工智能解決方案。

鑒於如此樂觀的AI新發展,蘇姿豐預計,2024年的數據中心GPU收入將超過45億美元,比4月時AMD提供的指引40億美元高出5億美元。

AMD追趕英偉達

去年8月時,英國《金融時報》曾預計H100或可在2024年為英偉達帶來500億美元的收入,若按此計算,平均每個季度的收入或超100億美元,AMD的MI300 GPU營收規模與此相比仍有很大差距,其於2024年第2季營收超10億美元。

在AMD持續更新AI發展路線圖的時候,英偉達也沒閑著,今年年初發佈了H100的升級版B100和B200 GPU,預計在今年稍後時間交付。3月時,英偉達發佈了「Blackwell」模型,可能在今年稍後或2025年交付。

值得留意的是,英偉達之前曾表示按「每年」一枚新「芯」的速度發佈新產品,而在此之前英偉達的發佈時間長達兩年,但在今年6月的台北電腦展開幕前夕,英偉達CEO黃仁勳發佈了新一代人工智能平台「Rubin」,將接替即將推出的Blackwell平台。該平台將配備新GPU、基於Arm的新CPU—Vera,以及採用NVLink 6、CX9 SuperNIC和X1600、並融合InfiniBand/以太網交換機的高級網絡平台。

據外媒wccftech報道,Blackwell GPU的第一代(B100/B200)將在今年稍後進入數據中心,而英偉達還計劃發佈一個增壓版本,該版本將具有8個站點的12Hi内存堆棧,而不是現有產品的8個站點的8Hi内存堆棧。該芯片預計將於2025年推出。

而新一代的Rubin R100 GPU將組成R系列產品線,預計會在2025年第4季量產,DGX和HGX解決方案等系統預計會在2026年上半年量產。據英偉達的說法,Rubin GPU和相應的平台將在2026年上半年推出,而Ultra版則會在2027年推出。英偉達還確認Rubin GPU將使用HBM4内存。

黃仁勳還宣佈,每年推出新的Spectrum-X產品的計劃,以滿足AI對高性能以太網網絡平台日益增長的需求。此外,英偉達還推出AI模型推理微服務NVIDIA NIM,通過已經優化的容器的形式提供模型,部署在雲、數據中心或工作站上。

儘管面對AMD和英特爾(INTC.US)的前後夾擊,還有終端客戶如特斯拉(TSLA.US)自研芯片以降低對其依賴的挑戰,英偉達在AI芯片市場仍一枝獨秀,佔據超過八成的市場份額,AMD在短期内恐怕仍難以趕上,但若未來的AI發展所帶來的回報未如預期,英偉達的前途也將面臨考驗。